| Articles | https://doi.org/10.21041/ra.v13i3.685 |

Clasificación supervisada de patologías en la superficie de los pavimentos de asfalto desde una Aeronave Pilotada Remotamente (RPA)

Classificação supervisionada de patologias na superfície de pavimentos asfálticos a partir de Aeronave Remotamente Pilotada (RPA) Supervised classification of pathologies in asphalt pavements surface from a Remote Piloted Aircraft (RPA)

G.

Legramanti1

*

![]() ,

R. D.

Duarte1

,

R. D.

Duarte1

![]() ,

E. V.

Gomes1

,

E. V.

Gomes1

![]() ,

S. L.

Dallagnol1

,

S. L.

Dallagnol1

![]() ,

D. R.

Bisconsini1

,

D. R.

Bisconsini1

![]() ,

H. S.

Felipetto1

,

H. S.

Felipetto1

![]() ,

L.

Moraes1

,

L.

Moraes1

![]()

1 Departamento de Engenharia Civil, Universidade Tecnológica Federal do Paraná, Pato Branco, Brasil.

*Contact author: gabriela-legramanti@hotmail.com

Recepción:

20

de

abril

de

2023.

Aceptación:

31

de

agosto

de

2023.

Publicación: 01 de septiembre de 2023.

| Citar como:Legramanti, G.,Duarte,R. D., Gomes Junior, E. V.,Dallagnol, S. L.,Bisconsini,D. R., Felipetto, H. S.,Moraes,L. (2023), "Clasificación supervisada de patologías en la superficie de los pavimentos de asfalto desde una Aeronave Pilotada Remotamente (RPA)", Revista ALCONPAT, 13(3), pp. 271 –285, DOI: https://doi.org/10.21041/ra.v13i3.685 |

Resumen

La identificación de defectos es una actividad rutinaria en los Sistemas de Gestión de Pavimentos (PMS) para la toma de decisiones sobre los servicios de Mantenimiento y Rehabilitación (M&R). Los métodos tradicionales pueden consumir mucho tiempo, interrumpir el tráfico y causar accidentes. En este estudio se evaluaron patologías sobre pavimentos asfálticos utilizando tres métodos: caminando, clasificación manual de imágenes desde una Aeronave Pilotada Remotamente (RPA) y clasificación supervisada. La clasificación manual dio como resultado una precisión del 93,1 %, frente al 32,7 % de la supervisada. Se concluye que el RPA es adecuado para evaluar patologías en pavimentos asfálticos, brindando ahorro de tiempo y seguridad.

Palabras clave:

pavimentos,

gestión de pavimentos,

patologías en pavimentos,

Aeronave Pilotada Remotamente,

RPA.

1. IntroducciÓn

El transporte por carretera es uno de los más utilizados en el mundo porque permite viajar puerta a puerta con buena flexibilidad. Para garantizar la seguridad, la comodidad y la economía a los usuarios, las carreteras deben mantenerse en condiciones adecuadas para la circulación. En este sentido, los Sistemas de Gestión de Pavimentos (SGP) son herramientas de gran utilidad para compañías privadas y organismos públicos encargados de la gestión de carreteras. Su objetivo es formalizar la toma de decisiones, asegurando la coherencia en las decisiones a diferentes niveles y el mejor uso posible de los recursos invertidos. El buen funcionamiento de un SGP, a su vez, depende de la alimentación continua de su base de datos compuesta de evaluaciones. Entre las evaluaciones más importantes de un SGP se encuentra la evaluación de patologías en la superficie, siendo uno de los principales relevamientos para la definición de estrategias de Mantenimiento y Rehabilitación (M&R) de pavimentos.

A pesar de su importancia, la recopilación de datos no es siempre eficiente y segura. En el caso de la evaluación de patologías superficiales en pavimentos, la inspección visual caminando es la más conocida. A pesar de ser ampliamente utilizado, este procedimiento requiere tiempo (Schnebele et al., 2015), tanto para la capacitación de los técnicos involucrados como para la recolección de datos en el campo. Además, está sujeto a errores humanos que afectan su confiabilidad (Shaghlil y Khalafallah, 2018). Por tanto, el desarrollo de nuevas tecnologías para el estudio de patologías es fundamental para minimizar la subjetividad de los métodos tradicionales y mejorar la productividad y repetibilidad de las evaluaciones (Ragnoli et al., 2018). En los últimos años se ha investigado el uso de RPA (Aeronaves Pilotadas Remotamente) para la evaluación de patologías en pavimentos (Zhu et al., 2021), con miras a una mayor seguridad para los usuarios y evaluadores, sin necesidad de bloquear el tráfico (Tan y Li, 2019), aportando buena repetibilidad y agilidad, además de la posibilidad de identificación automatizada de patologías (Pinto et al., 2020). Parente et al. (2017) observaron que la identificación manual de patologías desde una RPA presenta una diferencia menor en el área en comparación con el estudio de campo.

Ranyal et al. (2022) realizaron una revisión sistemática de la literatura, publicada entre 2017 y 2022, sobre tecnologías basadas en sensores de contacto y sin contacto destinadas a monitorear el estado de las carreteras. Los autores destacaron el protagonismo de los sensores inteligentes y las plataformas de recopilación de datos, como teléfonos inteligentes, drones y vehículos integrados equipados con sensores sin contacto, como RGB, cámaras termográficas, láseres y sensores GPR (Ground Penetrating Radar). En el caso de los UAV, señalan que las principales ventajas están relacionadas con el campo de visión que ofrecen, alta resolución, datos profundos y detallados, facilidad de aplicación y posibilidad de acceso a zonas de riesgo, además de flexibilidad para levantamientos rápidos. Por otro lado, también citan como desventajas la carga útil, las restricciones de memoria y las limitaciones legales de uso.

Considerando que la detección automática de carreteras por parte de vehículos aéreos no tripulados es un paso esencial para la aplicación de esta herramienta en la evaluación del estado de las carreteras, Ranjbar et al. (2023) crearon un método para detectar automáticamente los límites de las carreteras y segmentarlos utilizando datos temporales y geográficos, a través de su Unidad de Medición Inercial (IMU). Los autores probaron el método desarrollado en áreas urbanas y concluyeron que el sistema era capaz de realizarlo de manera eficiente, recomendando que en trabajos futuros se apliquen redes neuronales convolucionales (CNN) para aumentar la eficiencia del método.

Hassan et al. (2021) desarrollaron una CNN para la detección de carriles amarillos en carreteras con el fin de automatizar el estudio de grietas y baches a partir de imágenes de vehículos aéreos no tripulados. Se crearon trece capas convolucionales, una de salida softmax y dos integralmente conectadas, aplicándose activación mish a las primeras doce capas mediante una unidad lineal rectificada (ReLU), con el fin de lograr una propagación más profunda y evitar la saturación en la fase de entrenamiento. El modelo logró una precisión del 95%.

Astor et al. (2023) compararon la precisión de los levantamientos de defectos en pavimentos realizados por vehículos aéreos no tripulados con los obtenidos manualmente, a través de modelos de regresión obtenidos para el SDI (Surface Distress Index) y el PCI (Pavement Condition Index). El modelo de predicción PCI mediante imágenes de UAV alcanzó un R² de 0,86, frente a un R² de 0,653 para el modelo de predicción SDI.

Branco y Segantine (2015) delimitaron áreas fotografiadas utilizando polígonos para identificar patologías en pavimentos urbanos. Los autores encontraron dificultades debido a la presencia de vegetación y edificios de hormigón, que en algunos análisis fueron clasificados como pavimento. Pan et al. (2018) utilizaron algoritmos de aprendizaje automático como redes neuronales artificiales, máquinas de vectores de soporte y bosques aleatorios para clasificar grietas y baches en pavimentos. Entre los tres métodos, el modelo de bosque aleatorio de dieciocho árboles tuvo el mejor rendimiento de clasificación, con una precisión del 98,83%.

A pesar de los beneficios que pueden brindar las RPA, existen limitaciones a considerar para patologías topográficas, como la altura de vuelo, la resolución y calibración de la cámara y la calidad de la orientación de la imagen (Tan y Li, 2019), además del software y la clasificación de algoritmos utilizados (Zhu et al., 2021). Pan et al. (2018) señalan que la resolución espacial no debe exceder la escala mínima de los eventos de interés o se pierden detalles. En su investigación, el número de grietas no identificadas aumentaba cuando el tamaño del píxel era superior a 3 cm. Shaghlil y Khalafallah (2018) recomendaron alturas de vuelo entre 5 y 10 m, dependiendo la altura máxima de la resolución de la cámara. En este caso utilizaron una cámara de 12 megapíxeles. Con una cámara de 20 megapíxeles, Oliveira et al. (2020) obtuvieron un error promedio máximo de 1,06%, a una altura de 30 m, para la identificación de un parche, mientras que para 60 m, un error promedio máximo de 7,18%. Explican que la superposición de imágenes de una misma patología es decisiva para la precisión del método, ya que patologías de mayores dimensiones estarán presentes en varias capturas, generando así más información para la etapa de procesamiento.

En este estudio, se investigó la identificación automatizada de patologías en pavimentos asfálticos mediante clasificación supervisada de imágenes RPA, llenando un vacío importante en investigaciones relacionadas, ya que apunta a la precisión de la clasificación no solo calculando áreas similares de los elementos de interés, sino también en su ubicación. Además, incluye no sólo el método tradicional de evaluación de patologías caminando, sino también la clasificación visual de imágenes RPA, que permite, si no la identificación automatizada de patologías, una evaluación más segura, sin interferencias en el tráfico, atributos de gran relevancia en las actividades rutineras en el manejo de pavimentos, especialmente en vías de alto tráfico.

2. MÉtodo

El método se dividió en la planificación y realización del vuelo, la clasificación manual, la clasificación supervisada, los métodos comparativos y análisis estadístico de la clasificación supervisada.

2.1 Planificación y realización del vuelo

La aeronave utilizada para realizar el vuelo fue el modelo Phantom 4 Advanced del fabricante DJI (Dà-Jiāng Innovations) con batería para 30 minutos de uso. La cámara acoplada a la aeronave dispone de una lente con un campo de visión de 84º y una distancia focal de 8,8 mm/24 mm, equipada con un sensor CMOS (Semiconductor complementario de óxido metálico) de 1” y 20 Megapíxeles y RGB (Rojo, Verde y Azul) (DJI Brasil, 2017). Para el mapeo aéreo se consideraron los siguientes factores: clima soleado e incidencia lumínica adecuada, sin nubes; ventana de vuelo ideal, que es de 11 a.m. a 1 p.m.; velocidad y dirección favorables del viento; lugares de aterrizaje y despegue seleccionados según los obstáculos locales; y no interferencia en el espacio aéreo, solicitado a la Agencia Nacional de Aviación Civil (ANAC).

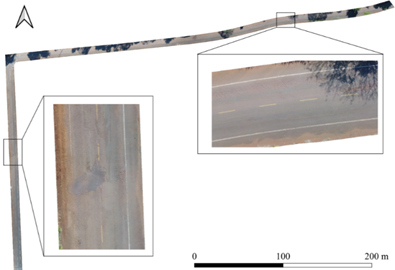

El tramo evaluado tiene una longitud de 600 m, con dos tramos perpendiculares entre sí, ubicado en la calle Irineu Parzianello, em el municipio de Pato Branco, estado de Paraná, Brasil, con coordenadas iniciales 26º11'55.14”S y 52º41'19.15''W , y finaliza em 26º12'4.92”S y 52º41'34.75”W. La sección presentó varias patologías de superficie, lo que permitió un análisis exhaustivo del porcentaje de corrección de los métodos de identificación patológicos y no patológicos. La presencia de vegetación aledaña al camino permitió la evaluación de elementos en presencia de sombra.

El plan de vuelo cumplió con los siguientes parámetros: cobertura lateral del 65%; 75% de cobertura longitudinal; y una velocidad máxima de 15 m/s, con una GSD (Distancia de muestreo del suelo) de 1,5 cm/px, lo que resulta en una altitud promedio de 50 metros. El tiempo aproximado de vuelo fue de 7 minutos. Para optimizar el ajuste del procesamiento de imágenes, se determinaron diez puntos de control (Ground Control Points - GCP) a lo largo del tramo elegido, de forma aleatoria e intercalados entre los lados de la pista. Se fijaron los objetivos y se determinaron sus respectivas coordenadas a través del receptor GNSS (Global Navigation Satellite System), modelo Zenith 25, mediante el método RTK (Real Time Kinematic). El procesamiento para crear el ortomosaico se realizó en el programa Agisoft PhotoScan, utilizado para referenciar las fotografías, corregir posiciones en relación a las coordenadas GNSS y realizar la ortorectificación para obtener el ortomosaico final utilizado en las clasificaciones manuales y supervisadas.

2.2 Clasificación manual de imágenes

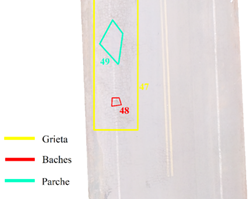

A partir del ortomosaico se realizó la clasificación manual de las patologías. Para ello se utilizó el software AutoCAD® 2018 para vectorizar cada elemento (Fig. 1).

|

||||

| Figura 8. Ejemplo. de delimitación manual de áreas de patología. | ||||

Para obtener datos de referencia para el levantamiento realizado con la RPA, se evaluaron patologías del pavimento caminando, identificando el tipo y extensión de las patologías, para verificar si las patologías existentes en la vía serían visibles en las imágenes obtenidas por el RPA.

2.3 Clasificación supervisada de imágenes

La clasificación supervisada de imágenes se realizó con la ayuda de un complemento de la plataforma QGIS (Quantum Geographic Information System): el SCP (Semi-Automatic Classification Plugin). A partir de la ortoimagen final, se creó un conjunto de bandas a través del complemento, equivalente al paso de preprocesamiento. En la primera etapa del procesamiento se definieron las categorías de interés: pavimento asfáltico en buen estado; grietas; baches; parches; vegetación (superpuesta a la carretera); y zonas con presencia de material arcilloso. A continuación, se seleccionaron muestras de cada elemento de interés para la clasificación, las cuales pueden tener como instrumento de captura un píxel o un polígono. Estas muestras alimentan el archivo de entrenamiento, obteniendo como resultado de la clasificación una imagen rasterizada.

Para estimar el método de clasificación supervisada más apropiado para la máquina utilizada, se probaron combinaciones de variables asociadas a los criterios de identificación, por píxel o por polígono, del algoritmo de clasificación, Distancia Mínima, Verosimilitud Máxima o Mapeo de Ángulo Espectral; y el número de muestras para el aprendizaje automático.

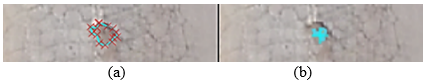

Para elegir el número de muestras acorde a la capacidad de la máquina, se recogieron aleatoriamente cuatro muestras de cada uno de los elementos para una primera prueba, ocho muestras para una segunda y dieciséis para una tercera, totalizando 24, 48 y 96 muestras. respectivamente. Utilizando el SCP se recolectaron muestras por píxel, donde se delimita el área con píxeles similares al seleccionado, y por polígono, donde el área se delimita manualmente (Fig. 2).

|

||||

| Figura 9. Ejemplos de muestreo por polígono (a) y por píxel (b) | ||||

En cuanto a los algoritmos de clasificación de imágenes, SCP proporciona tres opciones: (1) Distancia Mínima, que clasifica los píxeles por la distancia espectral promedio entre categorías, por distancia euclidiana, según la Ec. (1) (Richards, 2013):

Donde d x , y es la Distancia Euclidiana; x i : Vector de firma espectral de la imagen de píxeles; y i : Vector de firma espectral del área de una muestra; n: Número de bandas en la imagen.

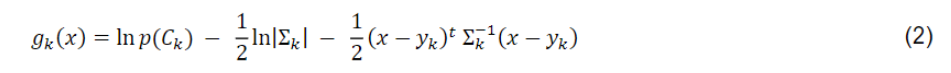

(2) Máxima Verosimilitud, que calcula la distribución de probabilidad normal de la clase, según la Ec. (2) (Richards, 2013):

Donde g k x es la Distribuición de probabilidad normal de la clase; x: Vector de firma espectral de la imagen de píxeles; C k : Clase de cobertura del suelo k; p ( C k ) : Probabilidad de que la clase correcta sea C k ; | Σ k |: Determinante de la matriz de covarianza de datos de la clase C k ; Σ k - 1 : Inversa de la matriz de covarianza; y k : Vector de firma espectral de clase k.

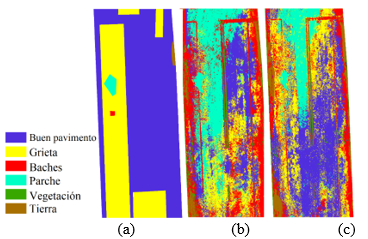

(3) Spectral Angle Mapping (Mapeo de Ángulo Espectral), que determina el grado de similitud entre curvas espectrales, según la Ec. (3) (Kruse et al., 1993):

Donde θ x , y es el Ángulo espectral; x i : Vector de firma espectral de la imagen de píxeles; y i : Vector de firma espectral del área de una muestra; n: Número de bandas en la imagen.

Luego de varias combinaciones entre criterios de identificación, algoritmo de clasificación y número de muestras, se encontraron las mejores para el estudio. Los resultados con mayor porcentaje de aciertos, respecto al tipo y extensión de las patologías, se obtuvieron con el clasificador de Maximum LikeliHood, mediante el método del polígono, con 24 y 48 muestras. Se descartaron combinaciones con más muestras debido a la capacidad de la máquina utilizada y al modo de funcionamiento del programa, que durante el procesamiento sobrecarga continuamente la memoria de la máquina.

2.4 Análisis comparativo y estadístico

Después de comparar la clasificación manual de imágenes con los datos de la evaluación caminando, la clasificación manual fue considerada como referencia para las clasificaciones supervisadas, debido a la alta conformidad de la clasificación manual con las patologías en el sitio.

Para evaluar estadísticamente la precisión del clasificador en la identificación de patologías se utilizó el índice Kappa, una técnica estadística multivariada. Se evaluó tanto la comparación de la clasificación supervisada con las muestras utilizadas para el entrenamiento del algoritmo como la clasificación supervisada con la manual. Los índices Kappa obtenidos son el resultado de la Matriz de Error (o confusión), proporcionada en el procesamiento posterior de QGIS, y la Matriz de Éxito Manual versus Supervisada, respectivamente. Además de esto, otro parámetro utilizado para el análisis de clases fue el Coeficiente de Correlación de Matthews (MCC).

2.4.1 Comparación de los éxitos de la clasificación supervisada en relación con la manual

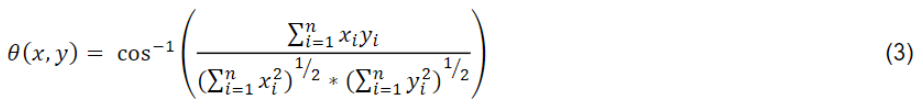

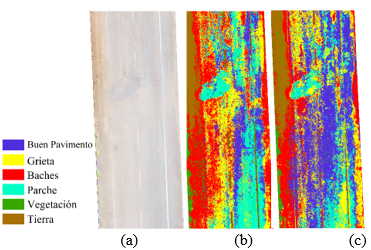

Con ayuda de QGIS, los polígonos obtenidos en la clasificación manual se superpusieron a los polígonos de la clasificación supervisada resultantes de la transformación de la imagen rasterizada en polígonos. Así se obtuvo el área común de ambas clasificaciones para cada elemento. Para verificar el porcentaje de identificación correcta de patologías, se confrontaron los resultados de la clasificación manual con los de la clasificación supervisada de 24 y 48 muestras. A modo de ejemplo, la Figura 3 muestra la misma sección clasificada manualmente (a) y supervisada, con 24 muestras (b) y 48 muestras (c).

|

||||

| Figura 3. (a) Manual, (b) Supervisado con 24 muestras y (c) Supervisado con 48 muestras. | ||||

2.4.2 Matriz de confusión

En la matriz de confusión, los valores de clase predichos para los datos de validación se comparan con los valores conocidos (Story; Congalton, 1986; Campbell; Hall-Beyer, 1997). Esta matriz asigna los valores reales de las clases del conjunto de validación a lo largo de las columnas con las clases predichas por el clasificador en las filas. Los píxeles correctamente clasificados se muestran a lo largo de la diagonal de la matriz, mientras que aquellos clasificados incorrectamente o confundidos con otra clase se muestran en celdas fuera de la diagonal (Mcgwire; Fisher, 2001).

Los verdaderos positivos (TP) y los verdaderos negativos (TN) consisten en clasificaciones correctas. Un falso positivo (FP) ocurre cuando la predicción del resultado es incorrecta, como sí (el positivo) cuando en realidad es no (negativo). Un falso negativo (FN) ocurre cuando se predice que el resultado será negativo cuando el resultado verdadero es positivo (Witten; Frank; Hall, 2016). A partir de estas frecuencias se obtienen indicadores de rendimiento de clasificación que reflejan la eficiencia del clasificador a la hora de detectar una clase determinada. Una matriz de confusión multiclase (k x k), como en el caso estudiado, se puede representar como un conjunto de k matrices de confusión binarias, una para cada clase, permitiendo su posterior procesamiento (Ruuska et al., 2018).

2.4.3 Estadísticas Kappa

El índice Kappa (K) fue creado por Jacob Cohen en 1960, con el objetivo de medir la precisión o grado de concordancia entre las categorizaciones predichas y observadas de un conjunto de datos (Cohen, 1960). El coeficiente también sirve para indicar el grado de concordancia entre la clasificación supervisada y los datos de referencia, que pueden ser las muestras utilizadas en el entrenamiento del algoritmo de clasificación, o una imagen de la clasificación manual definida como correcta. En los mapas, el grado de concordancia del índice Kappa puede variar entre 0 y 1, y cuanto más cerca de la unidad, mayor es el grado de concordancia. Se utiliza aquí la interpretación de la clasificación propuesta por Landis y Koch (1977), representada en la Tabla 1:

| Tabla 1. Nivel de acuerdo según el índice Kappa | |||||||||||||||||||

| Valor del Kappa | Interpretación | ||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0,00 - 0,20 | Mala concordancia | ||||||||||||||||||

| 0,21 - 0,40 | Concordancia débil | ||||||||||||||||||

| 0,41 - 0,60 | Concordancia moderada | ||||||||||||||||||

| 0,61 - 0,80 | Buena concordancia | ||||||||||||||||||

| 0,81 - 1,00 | Concordancia casi perfecta | ||||||||||||||||||

| Fuente: Adaptado de Landis y Koch. (1977). | |||||||||||||||||||

El índice Kappa (K) se calcula a partir de la siguiente expresión:

Donde P o es la proporción de concordancia observado, o precisión general, y P c es la proporción de concordancia casual o aceptación total. El término 푃 푂 viene dado por la siguiente división:

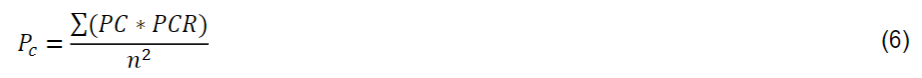

Donde TP es el número de verdaderos positivos, TN es el número de verdaderos negativos y n es el número total de píxeles clasificados. El término P C viene dado por la siguiente expresión:

Donde PC es el número total de píxeles clasificados en cada clase, PCR es el número total de píxeles en la clase real y n² es el cuadrado del total de píxeles.

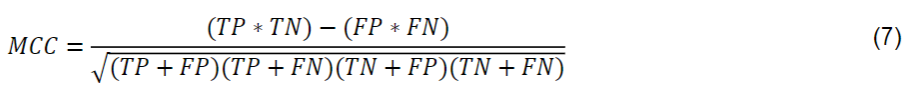

2.4.4 Coeficiente de correlación de Matthews

El coeficiente de correlación de Matthews (MCC) fue utilizado por primera vez por Matthews (1975). Según Baldi et al. (2000), se utiliza para medir la calidad de las clasificaciones. Sus valores oscilan entre -1 y +1, donde los coeficientes más cercanos a +1 representan un pronóstico consistente, los más cercanos a 0 representan pronósticos completamente aleatorios y los más cercanos a -1 representan un pronóstico inconsistente. El MCC se calcula a partir de la Eq. (7):

Donde TP es el número de verdaderos positivos, TN es el número de verdaderos negativos, FP es el número de falsos positivos y FN es el número de falsos negativos. Los píxeles de diferentes categorías pueden dar como resultado valores espectrales similares y provocar una clasificación errónea. Por lo tanto, es importante indicar el desempeño del clasificador en la detección de una clase determinada, y el MCC, tal como se determina a partir de la matriz binaria de cada categoría, cumple este rol.

3. Resultados y discusiÓn

Los resultados se presentan en cuatro temas: (i) vuelo y procesamiento, (ii) clasificación manual de imágenes, (iii) clasificación supervisada de imágenes y (iv) comparación de métodos y análisis estadístico de clasificación supervisada.

3.1 Vuelo y procesamiento

Luego de realizar el vuelo y procesar las imágenes obtenidas en el levantamiento RPA, se generó un ortomosaico final (Fig. 4). El GSD era de 1,39 cm por píxel. Con el objetivo de optimizar la clasificación, se recortaron de la imagen los bordes sobrantes que contenían el entorno más allá de los límites de la calzada.

|

||||

| Figura 4. Ortoimagen final con detalles de dos secciones. | ||||

3.2 Clasificación manual de imágenes

La clasificación manual de patologías de la superficie del pavimento fue relativamente rápida, debido a la facilidad de identificación mediante ortoimagen. Por otro lado, tras un control posterior con la evaluación caminando, se evidenció que las sombras de los árboles adyacentes a la vía dificultaban la visualización de algunas patologías y su extensión, principalmente grietas. Además, la vegetación ocultaba partes del pavimento.

En total, cinco patologías observadas en la evaluación caminando no fueron identificadas en las imágenes obtenidas por RPA. El área de parches, baches y grietas, observada en la recolección al caminar, fue de 1.759,45 m², mientras que en el levantamiento manual fue de 1.638,42 m², resultando en la identificación del 93,1% de las patologías. El porcentaje se calculó a partir de medidas geométricas registradas en croquis, a escala, en la encuesta de caminata.

3.3 Clasificación supervisada de imágenes

La clasificación de muestras por polígonos mostró pocas regiones acordes con el estado superficial real del pavimento, como se muestra en la Fig. 5. Además, resultó en clasificaciones diferentes en la mayoría de los elementos de la imagen seleccionados.

|

||||

| Figura 10. (a). Pavimento, (b) clasificación por polígonos con 24 muestras y (c) 48 muestras. | ||||

Píxeles de diferentes categorías, como buen pavimento y parches, presentaron tonalidades similares en algunas imágenes, lo que resultó en valores espectrales similares y, en consecuencia, en errores de clasificación. Se encontró que parte de los errores se produjeron por sombra y superposición de vegetación, lo que imposibilitó la clasificación de estas ubicaciones.

3.4 Análisis comparativo y estadístico

En este tema presentamos matrices de confusión y diagramas de dispersión generados a partir de la matriz de confusión resultante de la relación entre clasificaciones manuales y supervisadas, que se utilizan para calcular el índice Kappa (K) y el coeficiente de correlación de Matthews (MCC).

3.4.1 Comparación entre clasificaciones manuales y supervisadas

Para la comparación de clasificaciones manuales y supervisadas, la Tab. 2 presenta los resultados del método de Máxima Verosimilitud, mediante identificación por polígono, con 24 y 48 muestras, incluyendo áreas identificadas y porcentajes de respuestas correctas.

| Tabla 2. Resultados de la Comparación entre Clasificación Manual y Supervisada | ||||||||||||||

| Clases | Manual | Sup. 48 muestras | Superv. 24 muestras | |||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Áreas (m2) | Áreas (m2) | Correcto (%) | Áreas (m2) | Correcto (%) | ||||||||||

| Buen pavimento | 4419,39 | 1233,00 | 27,90 | 1346,67 | 30,47 | |||||||||

| Grieta | 1552,50 | 458,76 | 29,55 | 467,19 | 30,09 | |||||||||

| Baches | 2,53 | 1,24 | 49,01 | 0,66 | 26,09 | |||||||||

| Parche | 83,39 | 25,73 | 30,86 | 42,12 | 50,51 | |||||||||

| Vegetación | 247,40 | 186,14 | 75,24 | 192,52 | 77,82 | |||||||||

| Tierra | 29,45 | 22,2 | 75,38 | 20,00 | 67,91 | |||||||||

| Total | 6334,65 | 1927,06 | 30,42 | 2069,16 | 32,66 | |||||||||

La clasificación supervisada con 24 y 48 muestras dio como resultado un porcentaje de acierto global del 32,66% y 30,42%, respectivamente. Este resultado indica que el número de muestras no fue relevante para la precisión de la clasificación de áreas con o sin patologías.

3.4.2 Matrices de confusión y diagramas de dispersión

Las Tablas 3 y 4 representan matrices de errores de clasificación. Los términos 'Px', 'Pav' y 'clase', se refieren a Píxeles, Pavimento en buen estado y Clasificados, respectivamente. Las filas contienen datos ordenados, mientras que las columnas contienen datos de referencia. Los valores internos representan los píxeles, resaltando los píxeles correctamente identificados.

| Tabla 3. Matriz de confusión del clasificador con 24 muestras. | ||||||||||||||

| Pav. | Grieta | Baches | Parche | Vegetación | Tierra | Px class | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Pav. | 48682 | 9749 | 148 | 726 | 430 | 59735 | ||||||||

| Grieta | 3722 | 61794 | 123 | 667 | 1458 | 67764 | ||||||||

| Baches | 307 | 5885 | 489 | 222 | 1150 | 755 | 8808 | |||||||

| Parche | 9887 | 13114 | 24 | 12162 | 182 | 35369 | ||||||||

| Vegetación | 34 | 97 | 39 | 62564 | 207 | 62941 | ||||||||

| Tierra | 19 | 3 | 7 | 61161 | 61190 | |||||||||

| Px reais | 62632 | 90658 | 787 | 13816 | 65791 | 62123 | 295807 | |||||||

| Tabla 4. Matriz de confusión del clasificador con 48 muestras. | ||||||||||||||

| Pav. | Grieta | Baches | Parche | Vegetación | Tierra | Px class | ||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Pav. | 190051 | 12879 | 450 | 1130 | 551 | 11 | 205072 | |||||||

| Grieta | 18926 | 55103 | 785 | 1757 | 299 | 76870 | ||||||||

| Baches | 2367 | 4299 | 2354 | 1183 | 312 | 89 | 10604 | |||||||

| Parche | 9549 | 5383 | 229 | 12819 | 21 | 28001 | ||||||||

| Vegetación | 402 | 88 | 15 | 2 | 35516 | 17 | 36040 | |||||||

| Tierra | 309 | 12 | 44 | 26 | 6725 | 7116 | ||||||||

| Px reais | 221604 | 77764 | 3877 | 16891 | 36725 | 6842 | 363703 | |||||||

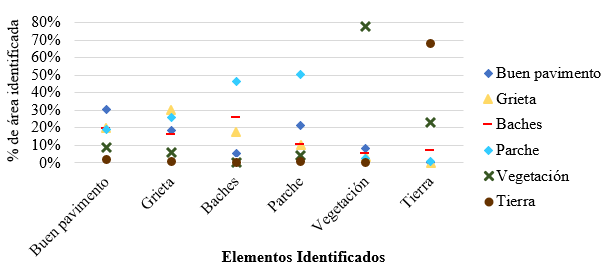

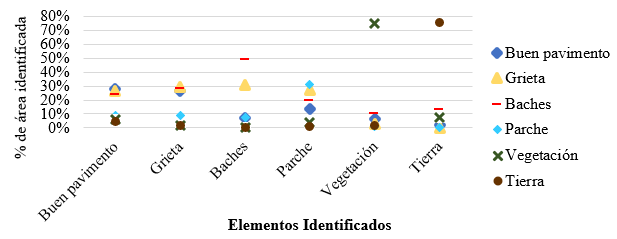

A partir de la superposición de polígonos definidos en el manual y clasificaciones supervisadas, se verificó la correspondencia de las patologías identificadas. Las Figuras 6 y 7 muestran los diagramas de dispersión del porcentaje de patologías identificadas, por clase, para 24 muestras (Figura 6) y 48 muestras (Figura 7), derivados de las matrices de confusión para estos casos.

|

||||

| Figura 11. Dispersión de la asertividad: clasificación supervisada 24 muestras x manual | ||||

|

||||

| Figura 12. Dispersión de la asertividad: clasificación supervisada 48 muestras x manual | ||||

Se observa, en la Fig. 6, que las clases de suelo y vegetación presentaron mejores resultados, con porcentajes de aciertos superiores al 60 y 70%, respectivamente. Buen pavimento, grietas y parche presentaron valores entre 30 y 50%, lo que puede entenderse como un mal resultado. Los baches presentan el peor resultado, con un acierto de aproximadamente el 25%, además de tener un mayor número de áreas clasificadas erróneamente como parches.

Como se muestra en la Fig. 7, se puede observar que los porcentajes de respuestas correctas fueron similares a los de la Fig. 6a, pero con un aumento significativo para los baches. Esto puede explicarse por la forma en que el algoritmo de Máxima Verosimilitud aplica la máxima verosimilitud (MaxVer). Según INPE (2006), el método pondera la distancia entre los valores promedio de píxeles del elemento a través de parámetros estadísticos, asumiendo que todas las bandas tienen una distribución normal, y calcula la probabilidad de que un píxel pertenezca a un elemento específico, con base en las muestras. Así, debido a que la clase de bote presenta diferentes características en una misma ocurrencia, el mayor número de muestras contribuyó a un mayor porcentaje de respuestas correctas para este clasificador.

3.4.3 Estadística Kappa

El índice Kappa fue calculado para cuatro escenarios, en dos comparaciones diferentes, la primera, y más conocida, se refiere al grado de concordancia entre categorías predichas por la clasificación supervisada, para 24 y 48 muestras, en relación a los datos obtenidos in situ. El segundo consiste en el grado de concordancia entre la clasificación supervisada y la clasificación manual, referida a la identificación visual y delimitación manual de patologías. Este análisis pretende dilucidar la relevancia del índice Kappa para el análisis de patologías en pavimentos mediante RPAs, basado en clasificación supervisada de imágenes. La Tabla 5 muestra los índices Kappa calculados a partir de las matrices de confusión presentadas en el ítem 3.4.2.

| Tabla 5. Índices Kappa para los cuatro casos. | ||||||||||||||

| Matriz Utilizada | 24 muestras | 48 muestras | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Supervised classification | 0,791 | 0,718 | ||||||||||||

| Overlapping manual and supervised ratings | 0,378 | 0,396 | ||||||||||||

Según la clasificación de Landis y Koch (1977), los índices de ambos clasificadores se encuentran entre 0,61 y 0,80, caracterizándose como buena concordancia. Sin embargo, cuando se observa la corrección superponiendo clasificaciones manuales y supervisadas, los valores de Kappa oscilan entre 0,21 y 0,40, lo que corresponde a una concordancia débil.

La discrepancia entre los valores Kappa, obtenidos por el clasificador y la superposición de clasificación manual y supervisada, muestra que el índice no es conveniente para el análisis cualitativo de patologías provenientes de RPAs, a pesar de ser ampliamente utilizado en detección remota. Cuantitativamente los algoritmos presentaron concordancia clasificada como buena. Sin embargo, no representaron fielmente las posiciones y geometrías de las patologías, lo que puede llevar a interpretaciones erróneas en cuanto a la precisión de la evaluación y, en consecuencia, en la toma de decisiones sobre estrategias de mantenimiento y rehabilitación de pavimentos.

3.4.4 Coeficiente de correlación de Matthews (MCC)

Debido a la similitud espectral de los elementos comprendidos en el proceso de clasificación, se analizó el desempeño del clasificador para 24 y 48 muestras de cada clase utilizando el MCC (Tab. 6).

| Tabla 6. Coeficiente de Correlación de Matthews obtenido para cada clase. | ||||||||||||||

| Clase | 24 muestras | 48 muestras | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Buen Pav. | 0,74 | 0,72 | ||||||||||||

| Grieta | 0,71 | 0,63 | ||||||||||||

| Baches | 0,18 | 0,35 | ||||||||||||

| Parche | 0,52 | 0,56 | ||||||||||||

| Vegetación | 0,96 | 0,97 | ||||||||||||

| Solo | 0,99 | 0,96 | ||||||||||||

Los resultados de clasificación para 24 y 48 muestras fueron similares. Al tener diferentes colores, a veces sombreados o con material arcilloso, los baches resultaron en más errores de clasificación. El elemento parche presentó MCC de 0,52 a 0,56, mientras que los elementos "grieta" y "buen pavimento" presentaron MCC superiores a 0,6 y 0,7, respectivamente, lo que indica que las grietas tienen mayor potencial para la clasificación automatizada.

4. ConclusiÓn

El estudio señala que la identificación de patologías asfálticas mediante RPA puede ser una alternativa al levantamiento tradicional, caminando, siendo más ágil y segura, además de no interrumpir el tráfico local. El buen nivel de detalle de las imágenes permitió una clasificación manual confiable (93,1% de precisión) en la identificación visual y representación del perímetro (extensión) de las patologías, al tomar como referencia los datos registrados en la evaluación caminando.

La clasificación supervisada, basada en RPA, es más compleja en comparación con la evaluación caminando, ya que depende de equipos específicos, una planificación adecuada de los planes de vuelo y técnicas y algoritmos de clasificación confiables. El número de muestras de entrenamiento no fue relevante, pero sí la forma en la que se seleccionó cada muestra, debiendo estandarizarse y realizarse de tal forma que el entrenamiento del algoritmo sea satisfactorio.

Los índices Kappa, obtenidos mediante la superposición de las imágenes de las clasificaciones manuales y supervisadas, deben usarse con precaución para el análisis de precisión de la clasificación, ya que, sin considerar la ubicación, analizada en este estudio superponiendo las patologías y verificando el tipo y extensión de cada elemento objetivo, puede llevar a interpretaciones erróneas sobre la asertividad de la clasificación y, en consecuencia, el estado de los pavimentos.

Los resultados obtenidos de análisis complementarios indican que la clasificación supervisada no mostró la precisión deseada para aplicaciones destinadas a la gestión de pavimentos, ya que no caracteriza en detalle las patologías, en cuanto a tipo, ubicación y extensión, en comparación con el estudio in situ y la clasificación manual de imágenes. En consecuencia, se recomienda que, en futuros estudios, se utilicen técnicas de tratamiento de imágenes que incluyan la combinación de coloración de píxeles, geometría patológica y pretratamiento de la imagen, además de la aplicación de otros algoritmos y técnicas de procesamiento que permitan el uso de un mayor número de muestras para el entrenamiento.

Referencias

Astor, Y., Nabesima, Y., Utami, R., Sihombing, A. V. R., Adli M. and Firdaus M. R. (2023), Unmanned aerial vehicle implementation for pavement condition survey. Transportation Engineering. 12(2023):100168. https://doi.org/10.1016/j.treng.2023.100168

Baldi, P., Brunak, S., Chauvin, Y., Andersen, C. A. F., Nielsen, H. (2000), Assessing the accuracy of prediction algorithms for classification: An overview. Bioinformatics, 16(5), 412-424. https://doi.org/10.1093/bioinformatics/16.5.412

Branco, L. H. C., Segantine, P. C. L. (2015), “MaNIAC-UAV - A methodology for automatic pavement defects detection using images obtained by Unmanned Aerial Vehicles”. Journal of Physics: Conference Series, 633(1). https://doi.org/10.1088/1742-6596/633/1/012122

Campbell, J. B., Hall-Beyer, M. (1997), “Introduction to remote sensing”. Cartographica, Toronto, Canadá, p. 70.

Cohen, J. (1960), A coefficient of agreement for nominal scales. Educational And Psychological Measurement, 10(1):37-46. https://doi.org/10.1177/001316446002000104

Kruse, F. A., Lefkoff, A. B., Boardman, J. W., Heidebrecht, K. B., Shapiro, A. T., Barloon, P. J., Goetz, A. F. H. (1993). “The spectral image processing system (SIPS)- interactive visualization and analysis of imaging spectrometer data” in: AIP Conference Proceedings 283, Pasadena: California (USA), pp. 145-163. https://doi.org/10.1063/1.44433

Hassan, S.-A., Rahim, T., Shin, S.-Y. (2021), An improved deep convolutional neural network-based autonomous road inspection scheme using unmanned aerial vehicles. Electronics. 10(22):2764. https://doi.org/10.3390/electronics10222764

INPE. Manual de Geoprocessamento. Disponível em: <http://www.dpi.inpe.br/spring/portugues/tutorial/introducao_geo.html>. Acesso: 8 out. 2021.

Landis, J. R., Koch, G. G. (1977), The Measurement of observer agreement for categorical data. Biometrics, 33(1):159-174. https://doi.org/10.2307/2529310

Matthews, B. W. (1975), Comparison of the predicted and observed secondary structure of T4 phage lysozyme. Biochimica et Biophysica Acta, 405(2):442-451. https://doi.org/10.1016/0005-2795(75)90109-9

McGwire, K. C., Fisher, P. (2001), Spatially Variable Thematic Accuracy: Beyond the Confusion Matrix. Spatial Uncertainty in Ecology, 308-329. https://doi.org/10.1007/978-1-4613-0209-4_14

Oliveira, F. H. L. de, Arantes, A. E., Lima Neto, P. D. S. (2020), Estudo de método para identificação de panelas e remendos em pavimentos urbanos com a utilização de UAS quadrirrotor. Revista Tecnologia, 41(2):1-14. https://doi.org/10.5020/23180730.2020.10838

Pan, Y., Zhang, X., Cervone, G., Yang, L. (2018), Detection of Asphalt Pavement Potholes and Cracks Based on the Unmanned Aerial Vehicle Multispectral Imagery. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 11(10):3701-3712. https://doi.org/10.1109/JSTARS.2018.2865528

Parente, D. C., Felix, N. C., Picanço, A. P. (2017), Utilização de veículo aéreo não tripulado (VANT) na identificação de patologia superficial em pavimento asfáltico. Revista ALCONPAT. 7(2):160-171. https://doi.org/10.21041/ra.v7i2.161

Pinto, L., Bianchini, F., Nova, V., Passoni, D. (2020), Low-Cost UAS Photogrammetry for Road Infrastructure's Inspection. International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences - ISPRS Archives, 43(B2):1145-1150. https://doi.org/10.5194/isprs-archives-XLIII-B2-2020-1145-2020

Ragnoli, A., De Blasiis, M. R., Di Benedetto, A. (2018), Pavement distress detection methods: A review. Infrastructures, 3(4):1-19. https://doi.org/10.3390/infrastructures3040058

Ranjbar H., Forsythe, P., Fini, A. A. F. and Maghrebi M. (2023), Addressing practical challenge of using autopilot drone for asphalt surface monitoring: road detection, segmentation, and following. Results in Engineering. 18(2023):101130. https://doi.org/10.1016/j.rineng.2023.101130

Ranyal, E., Sadhu A., Jain K. (2022), Road condition monitoring using smart sensing and artificial intelligence: a review. Sensors. 22(8):3044. https://doi.org/10.3390/s22083044

Richards, J. A. (2013), “Remote Sensing Digital Image Analysis”. Springer-Verlag Berlin Heidelberg, 5ed., Heidelberg, Alemanha, p. 340. https://doi.org/10.1007/978-3-642-88087-2

Ruuska, S., Hämäläinen, W., Kajava, S., Mughal, M., Matilainen, P., Mononen, J. (2018), Evaluation of the confusion matrix method in the validation of an automated system for measuring feeding behaviour of cattle. Behavioural Processes, 148:56-62. https://doi.org/10.1016/j.beproc.2018.01.004

Schnebele, E., Tanyu, B. F., Cervone, G., Waters, N. (2015), Review of remote sensing methodologies for pavement management and assessment. European Transport Research Review, 7(2):1-19. https://doi.org/10.1007/s12544-015-0156-6

Shaghlil, N., Khalafallah, A. (2018), “Automating Highway Infrastructure Maintenance Using Unmanned Aerial Vehicles” in: Construction Research Congress 2018, New Orleans: Louisiana (USA), pp. 486-495. https://doi.org/10.1061/9780784481295.049

Story, M., Congalton, R. G. (1986), Remote Sensing Brief - Accuracy Assessment: A User’s Perspective. Photogrammetric Engineering and Remote Sensing, 52(3):397-399. doi: 0099-1112/86/5203-397$02.25/0

Tan, Y., Li, Y. (2019), UAV photogrammetry-based 3D road distress detection. ISPRS International Journal of Geo-Information, 8(9):409. https://doi.org/10.3390/ijgi8090409

Witten, I. H., Frank, E., Hall, M. A. (2016), “Data Mining - Practical Machine Learning Tools and Techniques”. Morgan Kaufmann Elsevier, Burlington, pp. 654.

Zhu, Q., Dinh, T. H., Phung, M. D., Ha, Q. P. (2021), Hierarchical Convolutional Neural Network with Feature Preservation and Autotuned Thresholding for Crack Detection. IEEE Access, 9:60201-60214. https://doi.org/10.1109/ACCESS.2021.3073921